La motion capture (ou mocap) est devenue un outil incontournable dans les domaines du cinéma, du jeu vidéo, de l’animation et même de la réalité virtuelle. Elle permet de capturer les mouvements réels d’acteurs ou d’objets pour les appliquer à des personnages 3D. Longtemps réservée aux grands studios en raison de son coût, la mocap est aujourd’hui beaucoup plus accessible, notamment grâce à Blender, logiciel libre et puissant qui intègre des outils avancés pour exploiter des données de motion capture.

Dans ce guide, nous allons explorer en profondeur tout ce qu’il faut savoir pour travailler la motion capture dans Blender : sources de données, formats, pipelines, outils internes, plugins, bonnes pratiques et astuces.

Qu’est-ce que la Motion Capture ?

La motion capture consiste à enregistrer les mouvements d’un sujet (humain, animal ou objet) à l’aide de capteurs, caméras ou systèmes optiques. Ces données de mouvement sont ensuite converties en animations utilisables dans un logiciel 3D comme Blender.

Applications principales :

- Animation de personnages dans des films ou jeux vidéo

- Cinématiques temps réel

- Animation faciale (facial mocap)

- Prévisualisation (previz) en production

- Effets spéciaux (VFX)

Formats de Fichiers Motion Capture

Blender peut importer plusieurs formats standards de données mocap, notamment :

- BVH (Biovision Hierarchy)

- Très répandu, notamment dans les bases de données gratuites comme CMU Motion Capture.

- Contient la hiérarchie du squelette et les données d’animation.

- FBX

- Plus moderne, compatible avec de nombreux logiciels et outils mocap.

- Supporte les données complexes (animation, matériaux, meshes).

- C3D

- Utilisé dans les environnements scientifiques ou biomécaniques.

- Moins fréquent dans les pipelines artistiques.

- MOCAP proprietary formats

- Ex : formats propres à Rokoko, Xsens, Perception Neuron, etc.

- Nécessitent souvent un export en FBX ou BVH pour être lus dans Blender.

Sources Gratuites de Données Mocap

Si tu souhaites expérimenter la mocap dans Blender sans matériel coûteux, voici quelques ressources gratuites :

- CMU Motion Capture Database

- Immense bibliothèque de fichiers BVH (plus de 2600 motions).

- Mixamo (Adobe)

- Plateforme de rigging automatique et animations gratuites (avec compte Adobe).

- ActorCore

- Propose des animations gratuites (et payantes) en FBX.

- Motion Capture Online

- Petite sélection de BVH gratuits.

Pipeline de Motion Capture dans Blender

Travailler avec la mocap dans Blender implique plusieurs étapes :

1. Importer les Données Mocap

- BVH Import :

Fichier > Importer > Motion Capture (.bvh)

- FBX Import :

Fichier > Importer > FBX

Blender crée automatiquement un armature (squelette) animé à partir du fichier.

2. Nettoyage des Données Mocap

Les données mocap brutes peuvent être bruyantes ou comporter des erreurs. Les étapes fréquentes :

- Filtrage des clés parasites :

- Supprimer les mouvements parasites (petites oscillations).

- Lissage (Smoothing) :

- Utiliser le Graph Editor pour adoucir les courbes.

- Retiming :

- Modifier la vitesse ou la longueur de l’animation.

- Suppression d’offsets :

- Recentrer le personnage sur la grille.

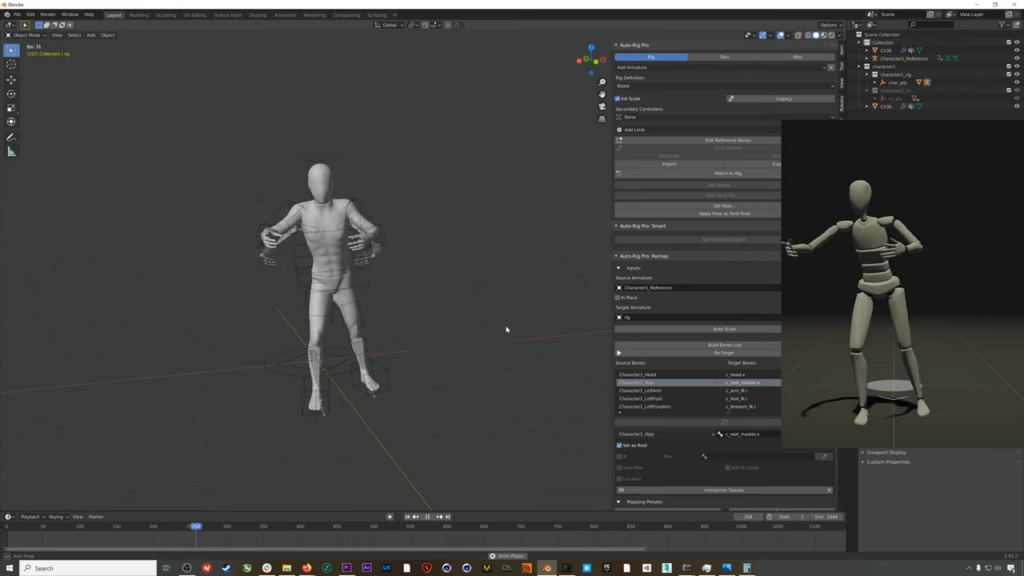

3. Retargeting : Appliquer la Mocap sur un Rig Personnalisé

Le rigging mocap généré par BVH ou FBX est souvent basique et ne correspond pas à ton personnage custom. Il faut donc transférer l’animation (retargeting) sur un autre rig, par exemple un rig Rigify ou un rig de production.

Méthodes de Retargeting dans Blender :

A. Add-on Auto-Rig Pro (Payant)

- Outil très puissant pour :

- Mapper automatiquement les os source/target.

- Retargeter des animations.

- Exporter vers des moteurs de jeu.

- Compatible avec Blender 3.x.

B. Add-on Rokoko Studio Live

- Si tu utilises Rokoko Studio, cet add-on permet de streamer la mocap en temps réel dans Blender.

C. Manuel avec Constraints

- Créer des contraintes (Copy Rotation, Copy Location) os par os.

- Fastidieux mais possible.

D. Blender’s Native NLA Editor

- Pour mixer des animations mocap entre elles ou avec des animations keyframées.

4. Ajustements Finaux

Même après retargeting, la mocap nécessite souvent :

- Nettoyage des mains/doigts

- Correction de la position des pieds (foot sliding)

- Retouches d’animation faciale

- Ajustements des expressions

Motion Capture Faciale

Blender permet également d’exploiter la motion capture faciale :

- iPhone ARKit

- Utilisable via des plugins tiers comme Face Cap ou FaceBuilder.

- Rokoko Face Capture

- Intégration possible dans Blender via FBX.

- Blend Shapes

- Souvent utilisés pour retargeter la mocap faciale.

Plugins et Add-ons Utiles pour la Mocap dans Blender

Auto-Rig Pro

- Rigging et retargeting ultra efficace.

- Interface simple.

- Compatible Unreal/Unity.

- Lien : Blender Market – Auto-Rig Pro

Rokoko Studio Live

- Permet de streamer la mocap depuis Rokoko Studio vers Blender.

- Temps réel ou offline.

- Nécessite Rokoko Studio.

- Lien : Rokoko – Blender Plugin

Retarget BVH

- Add-on gratuit.

- Permet de mapper les os d’un fichier BVH vers un rig existant.

- Gain de temps énorme.

- Lien : GitHub – Retarget BVH

FaceBuilder

- Plugin de KeenTools pour créer des têtes 3D basées sur des photos.

- Compatible avec mocap faciale.

- Lien : FaceBuilder

Motion Capture Tools

- Inclus dans Blender (activer “Motion Capture Tools” dans les add-ons).

- Outils basiques pour gérer l’import de mocap.

- Gratuit.

Conseils Pratiques

- Teste toujours la mocap sur un modèle simple avant de l’appliquer à ton personnage final.

- Prévois un nettoyage minutieux : la mocap n’est jamais parfaite telle quelle.

- Vérifie la cohérence des échelles (mètres vs centimètres).

- Surveille particulièrement le placement des pieds pour éviter le sliding.

- Utilise des proxy (modèles low poly) si tes scènes deviennent trop lourdes.

- Si tu exportes vers Unity ou Unreal, teste directement l’animation dans ces moteurs pour t’assurer que tout s’exporte correctement.

Motion Capture Temps Réel

Depuis quelques années, la mocap temps réel devient plus accessible :

- Rokoko Smartsuit Pro

- Perception Neuron

- Xsens

- Kinect (pour du mocap amateur)

- iPhone ARKit pour le visage

Blender peut recevoir des données live via des plugins spécifiques ou via OSC, rendant possible de l’animation en direct, très pratique en prévisualisation.

Les Limites de la Mocap

- Nettoyage indispensable : la mocap brute est rarement exploitable telle quelle.

- Pas toujours adaptée aux mouvements stylisés : elle peut manquer d’expressivité pour certains styles d’animation cartoon.

- Coût du matériel : même si cela baisse, un Smartsuit ou Xsens reste un investissement conséquent.

Conclusion

Blender est aujourd’hui un outil parfaitement capable de gérer la motion capture, de l’import brut au retargeting sur des rigs complexes. Que tu sois indépendant, freelance ou artiste dans un studio, tu peux intégrer la mocap dans ton workflow sans exploser ton budget grâce à des outils open-source ou à des plugins professionnels.

Si tu souhaites aller plus loin, investir dans des solutions comme Auto-Rig Pro ou Rokoko peut te faire gagner un temps précieux. Mais même sans budget, des ressources comme CMU Motion Capture ou Mixamo te permettront de créer des animations réalistes pour tes personnages.

La mocap sur Blender n’est plus réservée aux blockbusters : elle est désormais à la portée de tous ceux qui veulent animer vite… et bien.

Je m’appelle Timothée MEYRIEUX, je suis modélisateur 3D et scénariste. Je suis passionné par Blender ! Sur ce blog je partage ma passion et mes connaissances pour que tu puisses apprendre à utiliser Blender 3D pour tes projets !